„Buxtehude“, „Timbuktu“ oder „Wo der Pfeffer wächst“, die deutsche Sprache kennt einige Synonyme für abgelegene Orte. Aber wo liegen diese überhaupt? Und wie sieht es dort aus? Wie es in Buxtehude aussieht, ist von Bremen aus noch relativ leicht herausfinden: Die beiden Städte liegen nicht einmal hundert Kilometer auseinander. Timbuktu liegt hingegen in Afrika, genauer gesagt in Mali. Und der Pfeffer wächst noch weiter entfernt, nämlich an der Südspitze Indiens. Wie es dort aussieht, ist trotzdem nicht allzu schwer herauszufinden. Heutzutage gibt es wohl nur wenige Orte, von denen keine frei verfügbaren Luftaufnahmen vorliegen. Unsere Erde steht ständig unter Beobachtung. Und fotografische Luftbilder sind erst der Anfang.

Augen aus dem All

Die Erde wird umschwirrt von Satelliten. Viele dieser Satelliten tragen spezielle Messinstrumente, die der Erdbeobachtung dienen. Um zu verstehen, wie Satelliten die Erde beobachten, muss man sich jedoch zunächst damit auseinandersetzen, wie der menschliche Sehsinn funktioniert.

Panchromatisch und multispektral: das menschliche Auge

Als primär visuell ausgerichtete Lebewesen nutzen Menschen in erster Linie den Sehsinn, um Informationen über ihre Umwelt zu erhalten. Als Informationsträger dient dabei das Spektrum der elektromagnetischen Strahlung, das von der Sonne ausgeht. Dieses erstreckt sich von harter Röntgenstrahlung mit extrem kurzen Wellenlängen (< 0,1 Nanometer) bis hin zu langen Radiowellen (> 1 Kilometer). Ihre größte Intensität erreicht die Sonnenstrahlung im Wellenlängenbereich zwischen 380 und 780 Nanometern. Im Verlauf der Evolution hat sich das menschliche Auge darauf spezialisiert, genau diesen Bereich wahrnehmen zu können. Aus diesem Grund wird dieser gemeinhin als „sichtbares Licht“ bezeichnet. Einige der übrigen Wellenlängenbereiche werden von der Erdatmosphäre absorbiert, andere erreichen zwar den Erdboden, sind mit dem menschlichen Sehsinn aber nicht wahrnehmbar. Dazu zählen zum Beispiel UV- und Infrarotstrahlung.

Unabhängig von ihrer Sichtbarkeit für das menschliche Auge interagieren alle die Atmosphäre durchdringenden Strahlungsarten mit der Erdoberfläche und enthalten somit Informationen über deren Beschaffenheit. Aufgrund seiner begrenzten Empfindlichkeit für das Sonnenspektrum kann das menschliche Auge allerdings nur einen Bruchteil dieser Informationen aufnehmen.

Insbesondere bei geringen Lichtintensitäten ist die Funktion des menschlichen Auges eingeschränkt. In diesem Fall sind mit den sogenannten Stäbchen ausschließlich Rezeptoren eines einzigen Typs aktiv, wodurch lediglich eine Hell-Dunkel-Wahrnehmung der Umwelt im Wellenlängenbereich zwischen 400 und 600 Nanometern erreicht wird. Das bedeutet, dass bei geringer Lichtintensität keine Differenzierung verschiedener Wellenlängen und damit auch keine Farbunterscheidung möglich ist. Die entstehenden Bilder ähneln den Aufnahmen einer panchromatischen Kamera.

Bei ausreichender Beleuchtung stellt das Auge hingegen einen Multispektralsensor mit drei relativ breiten spektralen Aufnahmebändern dar. Auf der Netzhaut im Augeninneren sitzen drei verschiedene Unterarten von Farbrezeptoren, die sogenannten Zapfen, deren Sehfarbstoffe Absorptionsspitzen bei unterschiedlichen Wellenlängen aufweisen, sich in ihrer Empfindlichkeit aber teilweise überlappen. Im Gehirn wird die durch die Zusammensetzung der einfallenden Strahlung bedingte Aktivierung der einzelnen Zapfenarten verarbeitet und in ein farbiges Bild übersetzt. Ein violetter Farbeindruck entsteht dabei durch die kürzesten (ca. 380 bis 420 Nanometer), ein roter Farbeindruck durch die längsten noch wahrnehmbaren Wellenlängen (ca. 600 bis 780 Nanometer). Dazwischen liegen die Wellenlängenbereiche der übrigen Farbeindrücke. Zu beachten ist allerdings, dass ein bestimmter Farbeindruck sowohl durch Licht einer einzigen bestimmten Wellenlänge als auch durch Licht gemischter Wellenlängen entstehen kann. So kann beispielsweise der Farbeindruck „Gelb“ einerseits durch gelbes Licht, andererseits aber auch durch die Mischung von rotem und grünem Licht erzeugt werden.

Technische Sensoren für das elektromagnetische Spektrum

Technische Multispektralinstrumente weisen in der Regel eine höhere spektrale Auflösung auf als das menschliche Auge, allerdings handelt es sich auch bei einer gewöhnlichen Digitalkamera bereits um ein Multispektralinstrument. Wie das menschliche Auge können die Sensoren in einer Digitalkamera zwischen blauem, grünem und rotem Licht differenzieren und somit den Seheindruck des Auges wiedergeben. Für die Erdbeobachtung werden hingegen deutlich komplexere Multispektralinstrumente mit bis zu etwa fünfzehn Farbkanälen verwendet. Mit diesen können in der Regel unterschiedliche Wellenlängenbereiche des sichtbaren Lichts und der Infrarotstrahlung erfasst werden.

Die Daten der einzelnen Kanäle werden zunächst getrennt auf farbunempfindliche Sensoren aufgenommen und können als Graustufenbilder dargestellt und ausgewertet werden. Darüber hinaus können spektral unterschiedliche Aufnahmen derselben Fläche miteinander überlagert werden und unter Verwendung mathematischer Algorithmen auch zu farbigen Bildern kombiniert werden. Die Darstellbarkeit der aufgenommenen Informationen wird dabei wiederum von der Funktionsweise des menschlichen Sehsinns bestimmt.

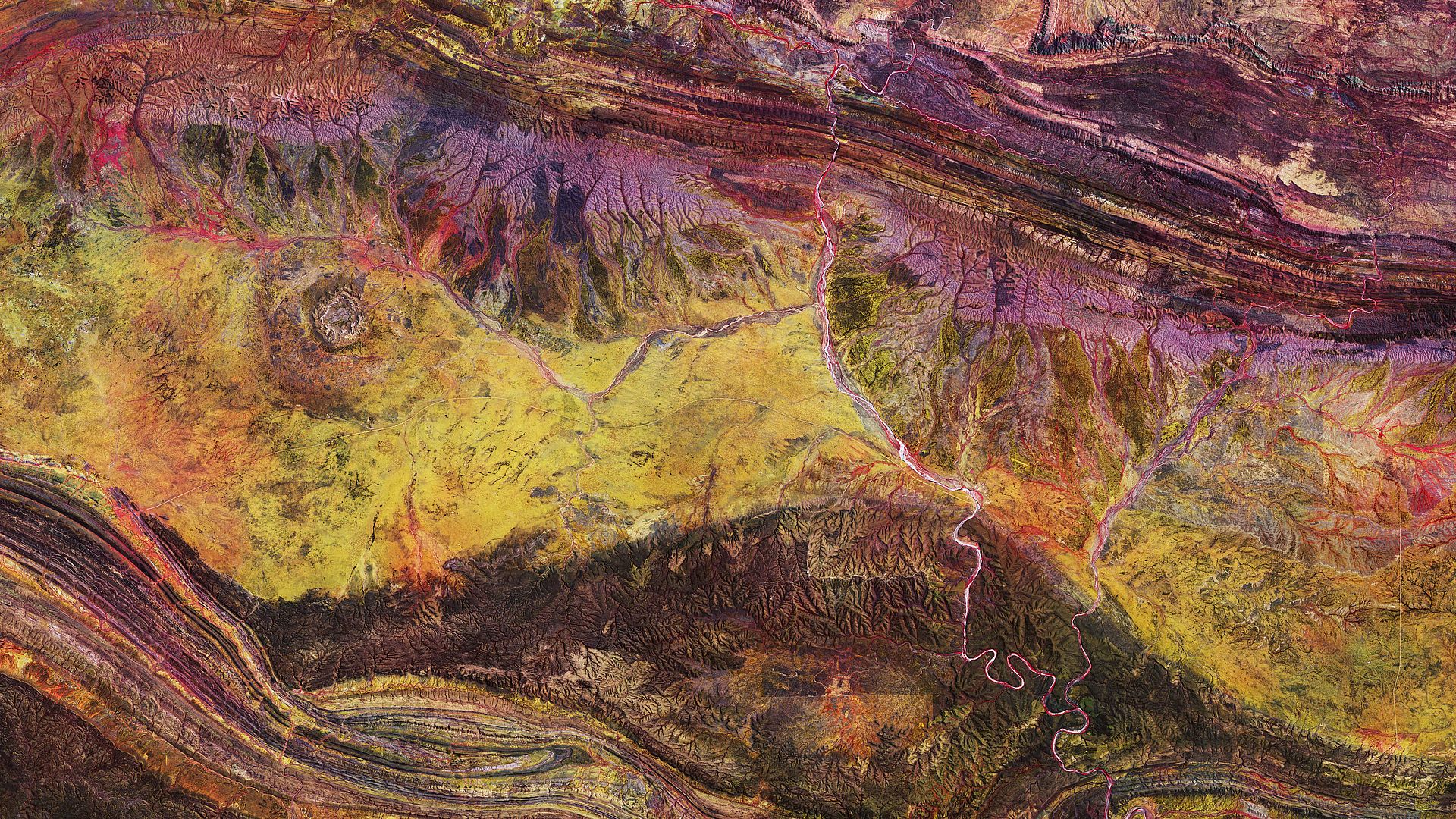

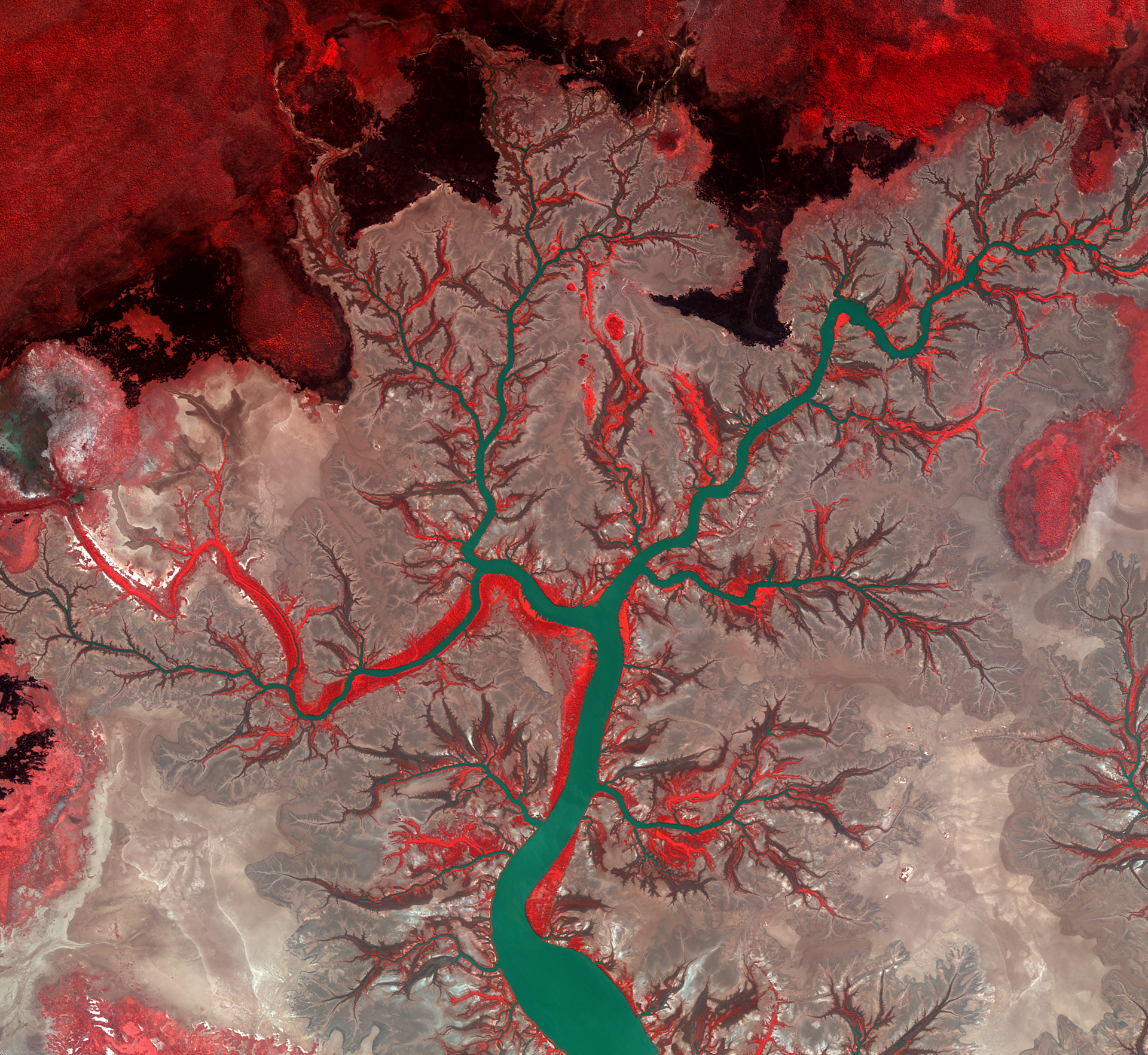

Wurden Aufnahmen in für den Menschen nicht sichtbaren Wellenlängenbereichen gemacht, muss den erfassten Daten für die bildliche Darstellung ein für den menschlichen Sehsinn wahrnehmbarer Spektralbereich und damit eine bestimmte Farbe zugewiesen werden. Welcher Wellenlängenbereich in welcher Farbe dargestellt wird, ist dabei freigestellt, in der Praxis haben sich aber bestimmte gängige Darstellungsweisen etabliert. So werden von Menschen erbaute Strukturen in den meisten Fällen in ihrem natürlichen Farbbereich aufgenommen und dargestellt, während für die gezielte Analyse von Böden, Vegetation und Gewässern häufig Aufnahmen in für das menschliche Auge unsichtbaren Spektralbereichen und eine Darstellung in Falschfarben gewählt werden.

Von panchromatisch bis hyperspektral

Die Hauptunterschiede zwischen der panchromatischen, multispektralen und hyperspektralen Datenerfassung sind die Breite und Anzahl der Aufnahmebänder. Während panchromatische Sensoren mit einem einzigen breiten Aufnahmeband arbeiten, besitzen Multi- und Hyperspektralinstrumente zur Steigerung der spektralen Auflösung eine größere Anzahl schmalerer Aufnahmekanäle. Hyperspektralsensoren können dabei bis zu mehreren hundert dicht nebeneinanderliegende Aufnahmebänder aufweisen.

Mit derartigen Instrumenten kann ein kontinuierliches Spektrum und damit eine Art „spektraler Fingerabdruck“ von Objekten aufgenommen werden. Dadurch können beispielsweise verschiedene Arten von Vegetation und unterschiedliche Bodenbeschaffenheiten anhand ihrer charakteristischen Absorptions- und Reflexionseigenschaften differenziert werden. Dabei ist die Informationsdichte so hoch, dass beispielsweise die Unterscheidung von Pflanzengesellschaften, mitunter auch einzelner Pflanzenarten oder Gesteinszusammensetzungen aus mehreren hundert Kilometern Entfernung möglich ist. Zudem kann anhand der Reflexionseigenschaften im Infrarotbereich der Gesundheitszustand von Vegetation erfasst werden: Gesunde Pflanzen produzieren den Blattfarbstoff Chlorophyll, der im Vergleich zum Bereich des sichtbaren (und insbesondere grünen) Lichts im Infrarotbereich sechsmal stärker reflektiert.

Genutzt werden diese Daten in erster Linie in der geografischen Fernerkundung und den Umweltwissenschaften. Hyperspektraldaten werden dabei zumeist nicht zur direkten Betrachtung verwendet. Vielmehr werden sie in komplexen mathematischen Verfahren, gemeinsam mit anderen Datenquellen, ausgewertet und verschnitten. Die daraus resultierenden Informationen über eine Eigenschaft der aufgenommenen Fläche können anschließend in thematischen Karten, beispielsweise Biotoptypenverteilungen, dargestellt werden.

Hyperspektralprojekte bei OHB

PRISMA

Bei PRISMA (PRecursore IperSpettrale della Missione Applicativa) handelt es sich um den Technologiedemonstrator einer neuen Generation von Erdbeobachtungssatelliten. Der Satellit trägt eine neuartige elektro-optische Nutzlast, die eine panchromatische Kamera mittlerer Auflösung mit einem Hyperspektralsensor kombiniert. Die panchromatische Kamera erlaubt dabei die Erfassung der Geometrie der Landschaft, während der Hyperspektralsensor Informationen über ihre chemische und physikalische Beschaffenheit liefert. Durch die Kombination der beiden Instrumente sollen die mit dem Hyperspektralsensor aufgenommenen Datensätze besser interpretierbar gemacht werden. Die entstehenden Bilder können dann für die Umweltbeobachtung, das Ressourcenmanagement, die Klassifizierung von Kulturpflanzen und weitere Anwendungen genutzt werden. Mit PRISMA soll das Prinzip validiert werden.

Das Observationskonzept von PRISMA beruht auf dem Prinzip der Zeilenkamera (Pushbroom oder Along Track Scanning). Dabei tastet der Satellit das Gelände rechtwinklig zur Flugrichtung zeilenweise ab. Der Hyperspektralsensor der von PRISMA getragenen Nutzlast verfügt über 239 Aufnahmebänder mit einer spektralen Auflösung von unter 12 Nanometern im Bereich zwischen 400 und 2500 Nanometern (sichtbares Licht bis kurzwelliges Infrarot). Die räumliche Auflösung liegt bei 30 Metern mit einer Aufnahmebreite von 30 Kilometern. Bei den gleichzeitig erfassten panchromatischen Daten liegt die räumliche Auflösung bei 5 Metern.

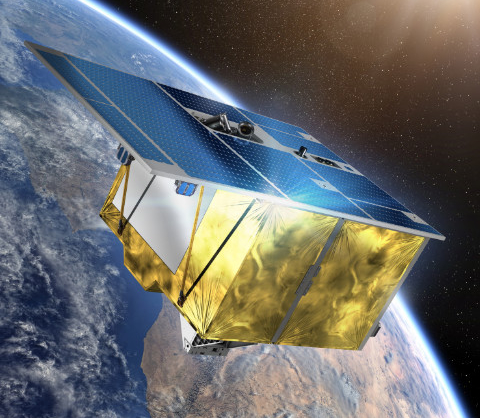

Das Projekt PRISMA wird komplett von der italienischen Weltraumagentur ASI finanziert. Die Satellitenplattform wurde von OHB Italia entwickelt und gebaut, die Nutzlast wurde von Leonardo Airborne and Space Systems beigesteuert. Am 22. März 2019 ist PRISMA erfolgreich mit einer Vega-Rakete vom europäischen Startplatz in Kourou gestartet.

EnMAP

EnMAP ist ein weiterer hochkomplexer Erdbeobachtungssatellit, der sich aktuell bei OHB in der Fertigung befindet. Das Hyperspektralinstrument, das der Satellit tragen wird, verfügt über zwei abbildende Spektrometer mit insgesamt 242 Aufnahmebändern im Wellenlängenbereich von 420 bis 2450 Nanometern. Die spektrale Auflösung liegt dabei bei 6,5 Nanometern im sichtbaren und nahinfraroten Bereich und bei 10 Nanometern im kurzwelligen Infrarotbereich. Dadurch wird der Satellit dazu in der Lage sein, die von der Erdoberfläche reflektierte Sonnenstrahlung vom sichtbaren Licht bis in den kurzwelligen Infrarotbereich in kontinuierlichen Spektren zu erfassen. Somit können spektral hochaufgelöste Aufnahmen angefertigt werden, die quantitative Aussagen über die mineralogische Zusammensetzung von Gesteinen, die Schädigung von Pflanzen durch Luftschadstoffe, die Wasserqualität von Seen und Küstengewässern oder den Grad der Bodenverschmutzung erlauben. Dies kommt den Geo-, Agrar- und Umweltwissenschaften zugute.

Der Satellit kann um 30 Grad geschwenkt werden, woraus für jeden beliebigen Punkt auf der Erdoberfläche eine mögliche Wiederbesuchszeit von maximal vier Tagen resultiert. Die räumliche Auflösung liegt wie bei PRISMA bei 30 Metern. Dadurch können mit EnMAP auch vergleichsweise schnell ablaufende räumlich-zeitliche Veränderungen, wie etwa Erosionsvorgänge oder Vegetationsperioden, dokumentiert werden.

Die wissenschaftliche Leitung des EnMAP-Projektes liegt beim Deutschen Geoforschungszentrum in Potsdam, die Gesamtprojektleitung obliegt dem DLR Raumfahrtmanagement. OHB entwickelt die Satellitenplattform und das Hyperspektralinstrument. Der Start des Satelliten ist für Anfang 2022 geplant, die wissenschaftliche Mission ist auf fünf Jahre ausgelegt.